¿Pueden Siri y Alexa escucharnos sin vulnerar nuestros derechos?

El entrenamiento de un sistema de inteligencia artificial debería hacerse en entornos de laboratorio y, en consecuencia, sobre un volumen de población concreto y con trabajadores cualificados

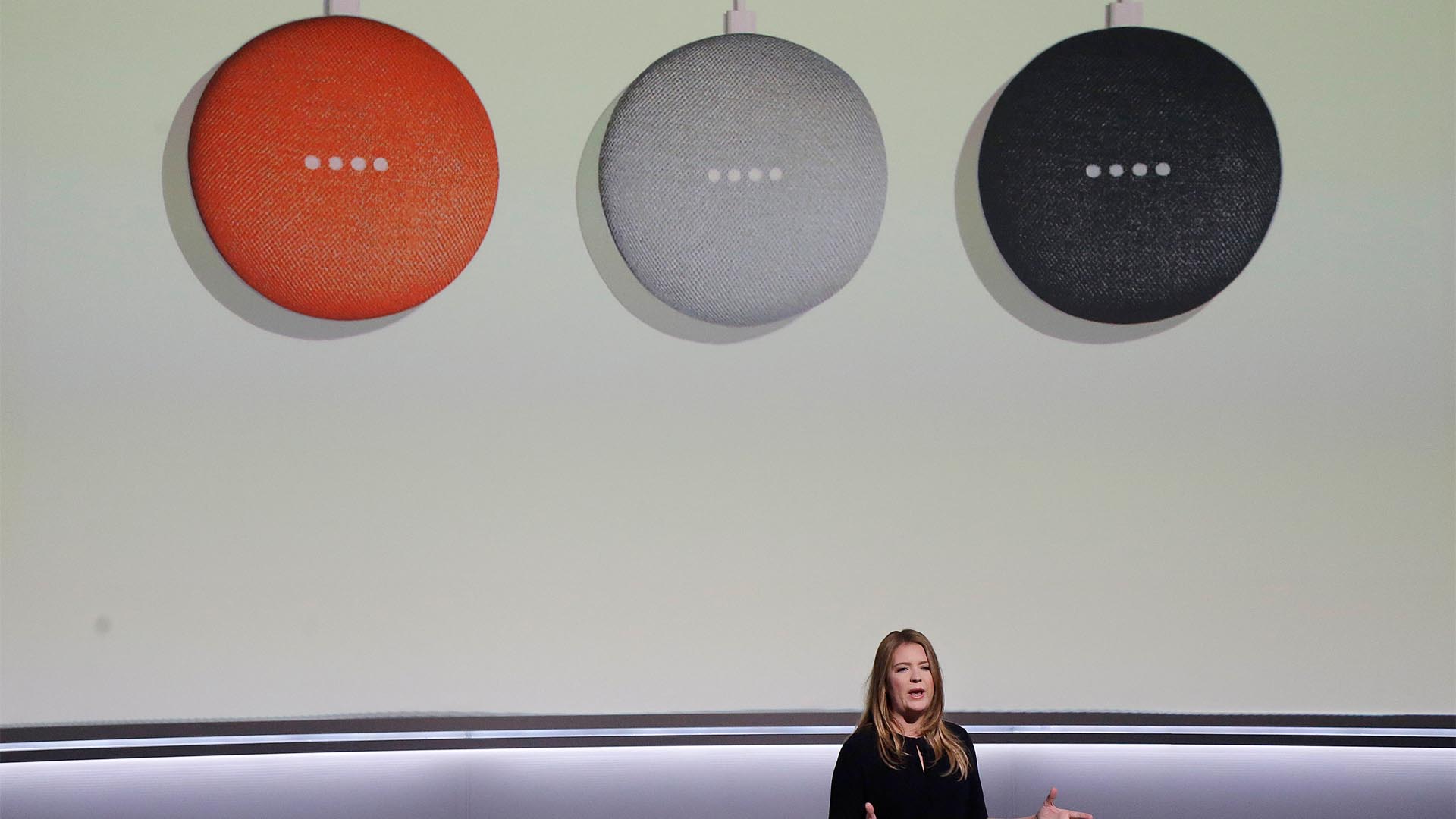

Los medios de comunicación, y con ellos los ciudadanos, han percibido con alarma la existencia de aplicaciones móviles que “escuchan” y empleados que revisan conversaciones de asistentes virtuales. Como consecuencia de la publicación de estas prácticas, Amazon ha añadido la opción de desactivar esta función en los dispositivos y Google y Apple han pausado sus programas de escucha mientras estudian habilitar una alternativa similar.

Para entender el impacto de estas actividades es necesario subrayar que los derechos a la intimidad, al secreto de las comunicaciones y a la protección de datos son derechos que solo ceden en los casos previstos en la Constitución y las leyes. También debemos comprender que la tecnología ha roto las barreras de lo físico haciendo pivotar la garantía de la privacidad sobre el valor cualitativo de la información: lo relevante son los bytes.

¿Por qué razón un asistente “escucha”?

Los procesos de inteligencia artificial (IA)[contexto id=”381729″] traducen al idioma de las máquinas el lenguaje natural para tomar decisiones o devolver información al usuario. Las IA necesitan ser entrenadas debido a la complejidad del lenguaje humano. No asimilan adecuadamente emociones, ambigüedades ni contextos. Adicionalmente, si no se verifica una correcta interpretación, existe un alto riesgo de generar sesgo en el funcionamiento.

La IA debe ser capaz de reconocer una voz, identificar el idioma, atribuir un significado, considerar el contexto y aislar interferencias. Su entrenamiento es fundamental. Pero ¿cómo la entrenamos? ¿Debe escuchar a un ser humano? La respuesta parece ser afirmativa y el modo en que dicha tarea se realice exige un diseño muy preciso.

¿Qué derechos se vulneran?

El hecho de que un asistente “escuche” puede repercutir, al menos, en los siguientes derechos:

– Intimidad. Por ejemplo, encargar la compra a un asistente revelará hábitos alimentarios, costumbres y rutinas e, incluso, aspectos relacionados con la vida sexual. Si, como en el caso de los asistentes Siri, Alexa y Google Assistant y aplicaciones como la app de la Liga de Fútbol Profesional “puede escuchar”, se captarán conversaciones y esto afectará a la intimidad familiar, a la libertad ideológica, etc. Podríamos añadir repercusiones ad infinitum.

– Secreto de las comunicaciones. Si el asistente vocal se usa para componer y remitir un mensaje, la información debería estar protegida por el secreto de las comunicaciones. Sería imposible acceder a ella sin vulnerar gravemente derechos fundamentales e, incluso, cometer delitos potencialmente. Y ello con un elemento añadido, ¿qué sucede si no se dispone de un consentimiento de todas las partes implicadas en la comunicación?

– ¿Inviolabilidad del domicilio? Cuando un asistente o aplicación se conecta desde un domicilio sin autorización del usuario, ¿se vulnera la inviolabilidad del domicilio? El Tribunal Constitucional ha considerado que este derecho permite “vedar toda clase de invasiones incluidas las que puedan realizarse sin penetración directa por medio de aparatos mecánicos, electrónicos u otros análogos” (STC 22/1984).

– Otros derechos. Si nos centramos en el contenido de la información, el riesgo de vulneración se traslada a cualquier derecho. Y no solo los propios de personas físicas. Un asistente vocal activado remotamente, podría estar escuchando secretos empresariales.

Así que resulta perfectamente lógico que se genere alarma social cuando leemos en la prensa que hay personas escuchando grabaciones.

¿Cómo deberían escucharse las grabaciones?

El sentido común dicta que una vez cumplida la finalidad de la interacción entre el usuario y el asistente, la información debería desaparecer. Las noticias desmienten que esté sucediendo. Parece necesario verificar un 0,2% de los registros con la finalidad de mejorar los procesos, entrenar la IA y evitar errores de funcionamiento y sesgo. Para la población todas estas necesidades pueden resultar desconocidas.

Si para entrenar una IA es crucial escuchar, es necesario responder varias preguntas:

▪ ¿Es ineludible escuchar conversaciones para entrenar un sistema de IA que trabaja con lenguaje natural? Si la respuesta es afirmativa, deben precisarse las condiciones: qué volumen, en qué contexto, bajo qué condiciones.

▪ ¿Cómo deberíamos regular jurídicamente estos procesos? La intimidad, la inviolabilidad del domicilio y el secreto de las comunicaciones son derechos irrenunciables, inalienables e imprescriptibles. Pero las personas pueden renunciar a su ejercicio. Y para ello se han definido modelos y procedimientos contractuales muy precisos en ámbitos como el del derecho a la propia imagen. Por ejemplo, nuestra imagen puede ser explotada con fines publicitarios o promocionales, y también podemos ceder espacios de intimidad cuando aceptamos colaborar en una investigación sociológica. En este sentido, el entrenamiento de una IA debería hacerse en entornos de laboratorio y, en consecuencia, sobre un volumen de población concreto a través de programas con arreglo a modelos de consentimiento y una contratación específica.

▪ ¿Cuáles son o deberían ser las condiciones de seguridad de estos tratamientos? El entorno de seguridad debe diseñarse adecuadamente. Los trabajadores que escuchan habrán sido escogidos por sus cualidades personales y profesionales y recibido un entrenamiento previo que asegure un comportamiento ética y jurídicamente irreprochable.

No basta, por tanto, con unas políticas de privacidad genérica que nadie lee. Si, una vez más, ha primado la rapidez del desarrollo tecnológico, nos enfrentaremos a un grave problema. La sociedad necesita confianza en el desarrollo de la inteligencia artificial y una garantía de nuestros derechos que va más allá de meras formalidades en un proceso de contratación online. Recuerden, no protegemos datos, protegemos personas.

Este artículo fue publicado originalmente en The Conversation. Lea el original.

![]()