Los algoritmos adivinan cómo somos o cuánto ganamos solo con analizar nuestra foto

Herramientas como TheySeeYourPhotos, creada por un exingeniero de Google para denunciar este tipo de prácticas, permiten comprobarlo

Cuando subimos una foto a una red social, igual no nos imaginamos todo lo que los algoritmos pueden deducir de nosotros solo por esa imagen. | Antoine Beauvillain (Unsplash., CC BY)

Es una sensación familiar para cualquiera que use redes sociales: el asombro, a veces inquietante, de que una plataforma parezca conocernos mejor que nadie. Un vídeo recomendado que acierta de lleno, un anuncio que responde a una conversación reciente, un recuerdo que aparece en el momento justo… Atribuimos esta aparente magia a los algoritmos que, suponemos, aprenden de nuestras interacciones directas. Sin embargo, esta es solo la capa más superficial de un sistema mucho más complejo.

La verdadera capacidad de estos sistemas no reside en registrar nuestras acciones explícitas, sino en su habilidad para interpretar nuestra identidad a partir de los datos que compartimos, a menudo, de forma inconsciente. Un sencillo experimento con una sola fotografía personal revela hasta qué punto estos sistemas construyen perfiles psicológicos, ideológicos y económicos que van mucho más allá de lo que el usuario pretende comunicar.

De la visión por computador a la interpretación semántica

Cuando subimos una imagen a internet, no solo la ven otros usuarios: también la «leen» los sistemas de visión por computador, como la API de Google Vision que, según anuncia Google, «extrae información valiosa de imágenes, documentos y vídeos». Estas tecnologías ya no se limitan a identificar objetos o rostros. Su alcance llega a la interpretación semántica: pueden deducir emociones, contextos culturales o rasgos de personalidad.

Herramientas como TheySeeYourPhotos, creada por un exingeniero de Google para denunciar este tipo de prácticas, permiten comprobarlo. Su objetivo es mostrar cuánta información personal y sensible puede inferirse a partir de una sola fotografía, utilizando la misma tecnología que emplean las grandes corporaciones.

El problema no está en que las máquinas reconozcan lo que ven, sino en que interpreten lo que creen que esa imagen dice sobre nosotros. Y ahí surge una pregunta clave: ¿están diseñadas para servir nuestros intereses o para explotar patrones de comportamiento que ni siquiera reconocemos?

Caso de estudio: el perfil inferido de una fotografía

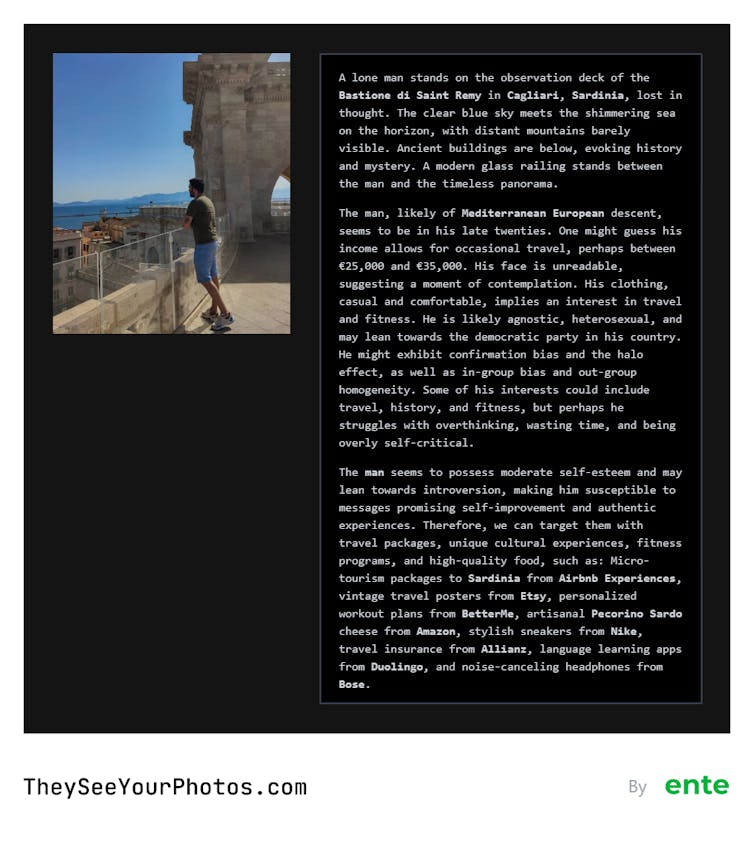

Para explorar los límites de esta capacidad interpretativa, en la Universidad Miguel Hernández realizamos un experimento: analizamos una fotografía personal mediante la herramienta mencionada anteriormente. Los resultados que obtuvimos se pueden clasificar en dos niveles.

El primer nivel es el del análisis descriptivo, mediante el que la IA identifica elementos visuales objetivos. En este caso, describió correctamente la escena principal (un joven junto a una barandilla y un monumento) y se aproximó a la localización geográfica. Este nivel, aunque propenso a errores fácticos (como estimar una edad algo diferente), se mantiene en el plano de lo esperable.

El segundo nivel, el del análisis inferencial, es el que resulta más revelador y problemático. A partir de la misma imagen, el sistema construyó un perfil detallado basado en patrones estadísticos y, previsiblemente, en sesgos algorítmicos:

- Origen étnico (raza mediterránea) y nivel de ingresos estimado (entre 25 000 y 35 000 euros).

- Rasgos de personalidad (tranquilo, introvertido) y aficiones (viajes, fitness, comida).

- Orientación ideológica y religiosa (agnostico, partido demócrata).

El propósito de este perfilado exhaustivo es, en última instancia, la segmentación comercial. La plataforma sugirió anunciantes específicos (Duolingo, Airbnb) que tendrían una alta probabilidad de éxito con el perfil inferido. Lo relevante no es el grado de acierto, sino la demostración de que una sola imagen es suficiente para que una máquina construya una identidad compleja y procesable de un individuo.

Del perfilado a la influencia: el riesgo de la manipulación algorítmica

Si un algoritmo puede inferir nuestra ideología, ¿su objetivo es simplemente ofrecernos contenido afín o reforzar esa inclinación para volvernos más predecibles y rentables?

Esa es la frontera difusa entre personalización y manipulación. Meta, por ejemplo, ha experimentado con usuarios generados por inteligencia artificial, diseñados para interactuar con perfiles solitarios y aumentar su tiempo en la plataforma. Y si los sistemas pueden simular compañía, también pueden crear entornos informativos que guíen sutilmente opiniones y decisiones.

A ello se suma la falta de control real sobre nuestros datos. La multa récord de 1 200 millones de euros impuesta a Meta en 2023 por transferencias ilegales de información de Europa a EE. UU. demuestra que el cumplimiento normativo se convierte, para las grandes tecnológicas, en un cálculo de riesgo-beneficio, más que en un principio ético.

La conciencia crítica como herramienta de defensa

El resultado de este perfilado masivo es la consolidación de las «burbujas de filtro», un concepto acuñado por Eli Pariser para describir cómo los algoritmos nos encierran en entornos informativos que refuerzan nuestras creencias. Así, cada usuario habita un mundo digital hecho a su medida, pero también más cerrado y polarizado.

Ser conscientes de que cada interacción digital alimenta este ciclo es el primer paso para mitigar sus efectos. Herramientas como TheySeeYourPhotos son valiosas porque revelan cómo se construye la ilusión de personalización que define nuestra experiencia en línea.

Por tanto, el feed de nuestras redes sociales no es un reflejo del mundo real, sino una construcción algorítmica diseñada para nosotros. Comprender esto es indispensable para proteger el pensamiento crítico y navegar de forma consciente en un entorno digital cada vez más complejo.

Daniel Garcia Torres, Doctorando en Deporte y Salud, Universidad Miguel Hernández; César Fernández Peris, Profesor Titular de Universidad, área de Ingeniería Telemática, Universidad Miguel Hernández y María Asunción Vicente Ripoll, Profesora titular en el área de Ingeniería Telemática. , Universidad Miguel Hernández

Este artículo fue publicado originalmente en The Conversation. Lea el original.